Nun will auch Apple den Kampf gegen Missbrauch von Kinder und Jugendlichen aktiv unterstützen. So gleicht man künftig automatisiert Inhalte von iCloud Fotos mit einer Datenbank von Missbrauchsaufnahnahmen ab, welche dort in Form von Hashs vorliegen.

Das Scannen von Fotos nach CSAM (Child Sexual Abuse Material) ruft aber zu gleich die US-Datenschützer auf den Plan. So befürchten diese ein hohes Missbrauchspotential der Funktion. Andere Unternehmen wie Microsoft, Google, Facebook, Twitter oder auch Adobe setzen derartige Technologien bereits seit einigen Jahren ein. Meldet das System einen oder mehrere Treffer werden die betroffenen Inhalte erst von Mitarbeitern des jeweiligen Unternehmens überprüft. Entdecken diese dann entsprechendes Material, ergeht eine Meldung an die Strafverfolgungsbehörden.

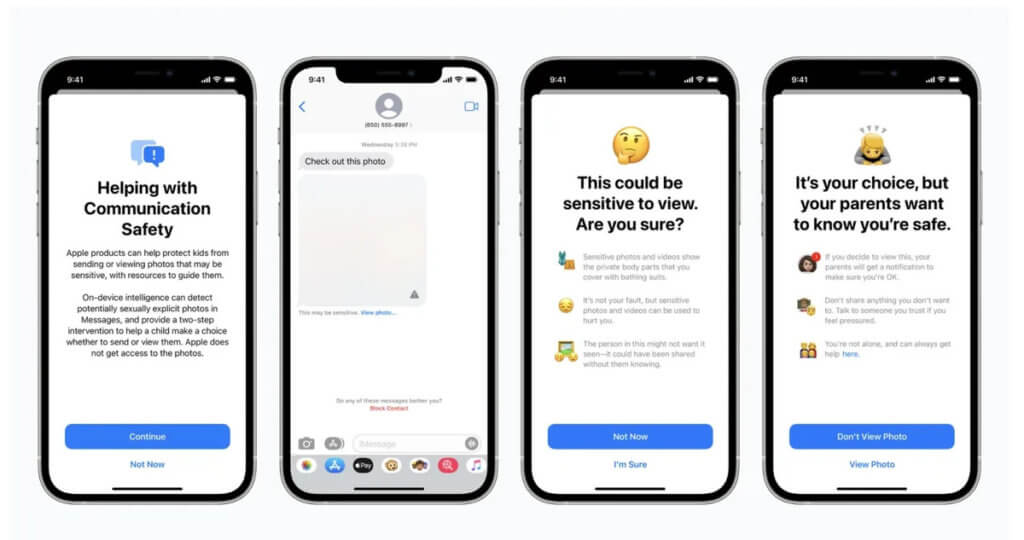

Auch iMessage bekommt kommt unter den Scanner

So sollen künftig auch Kinder und deren Eltern gewarnt werden, wenn diese eindeutige Fotos mit sexuellen Darstellungen erhalten oder versenden (möchten). Nach Angaben von Apple verwendet man zur Erkennung derartiger Fotos maschinelles Lernen auf dem Gerät, womit Fotos analysiert werden. Wird von diesem System ein Foto als sexueller Inhalt eingestuft, wird das Foto automatisch unscharf und das Kind davor gewarnt. Je nach Einstellung können die Eltern auch eine entsprechende Benachrichtigung erhalten, wenn der eigene Nachwuchs derartige Fotos empfängt oder versendet. Die Ende-zu-Ende-Verschlüsslung soll trotz dieses Verfahrens laut Apple erhalten bleiben, womit die Kommunikation nicht durch den Anbieter mitgelesen werden kann.